It's Literally Just Mowing adalah tepat seperti namanya—keseronokan penjagaan rumput yang tulen dan tidak rumit Kini tersedia di Apple Arcade, permainan kasual yang menenangkan ini menjemu anda untuk

Pengarang: GraceMembaca:0

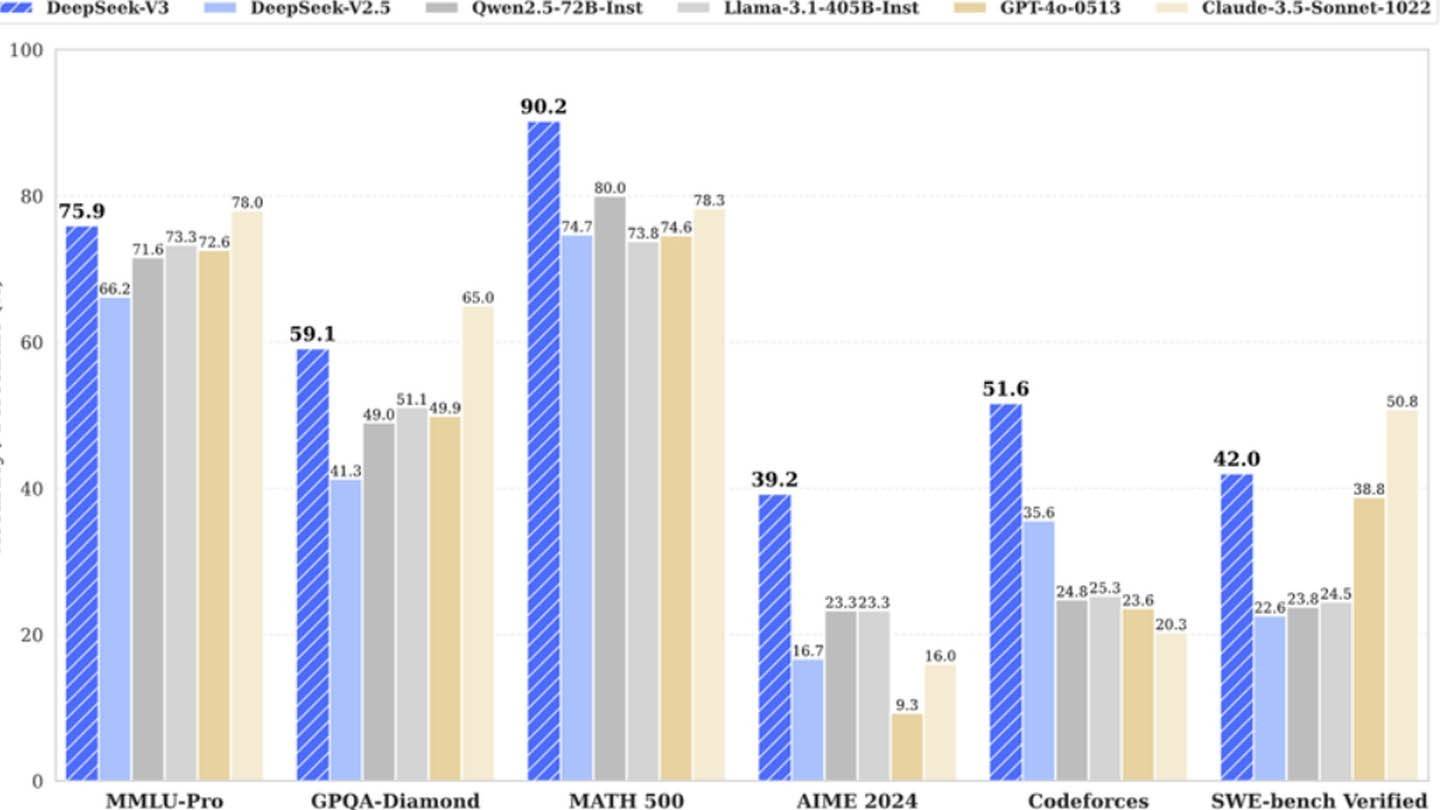

Deepseek yang menghairankan model AI yang murah mencabar gergasi industri. Permulaan Cina mendakwa telah melatih rangkaian neural Deepseek V3 yang kuat untuk hanya $ 6 juta, hanya menggunakan 2048 GPU, yang sangat berbeza dengan kos pesaing yang jauh lebih tinggi. Walau bagaimanapun, angka yang seolah-olah rendah ini hanya mencerminkan penggunaan GPU pra-latihan dan tidak termasuk penyelidikan, pemprosesan data, dan perbelanjaan infrastruktur yang besar.

imej: ensigame.com

imej: ensigame.com

Senibina inovatif Deepseek V3 menyumbang kepada kecekapannya. Teknologi utama termasuk Ramalan Multi-Token (MTP), yang meramalkan pelbagai perkataan secara serentak; Campuran Pakar (MOE), menggunakan 256 rangkaian saraf untuk latihan dipercepatkan; dan perhatian laten multi-kepala (MLA), memberi tumpuan kepada elemen kalimat penting untuk ketepatan yang lebih baik.

imej: ensigame.com

imej: ensigame.com

Walau bagaimanapun, pandangan yang lebih dekat mendedahkan pelaburan yang besar. Semianalysis mendedahkan penggunaan DeepSeek kira -kira 50,000 NVIDIA Hopper GPU, bernilai kira -kira $ 1.6 bilion, dengan kos operasi mencecah $ 944 juta. Ini bertentangan dengan tuntutan awal $ 6 juta.

imej: ensigame.com

imej: ensigame.com

Kejayaan DeepSeek berpunca daripada gabungan faktor: pembiayaan yang besar (lebih daripada $ 500 juta yang dilaburkan dalam pembangunan AI), kemajuan teknologi, dan pasukan yang sangat mahir memperoleh gaji yang besar (beberapa melebihi $ 1.3 juta setahun). Struktur bebas dan pemilikan pusat datanya menyumbang kepada ketangkasan dan kecekapannya.

imej: ensigame.com

imej: ensigame.com

Walaupun naratif "mesra bajet" Deepseek boleh dikatakan melambung, pencapaiannya tetap signifikan. Syarikat itu menunjukkan bahawa entiti AI yang dibiayai dengan baik dapat bersaing dengan pemain yang ditubuhkan, walaupun pelaburan besar akhirnya diperlukan. Sebaliknya adalah sangat membandingkan kos latihan: DeepSeek's R1 berharga $ 5 juta, manakala CHATGPT4 menelan kos $ 100 juta yang dilaporkan. Walaupun kos sebenar yang lebih tinggi, model DeepSeek kekal lebih murah daripada pesaingnya.

Artikel terkini

Artikel terkini